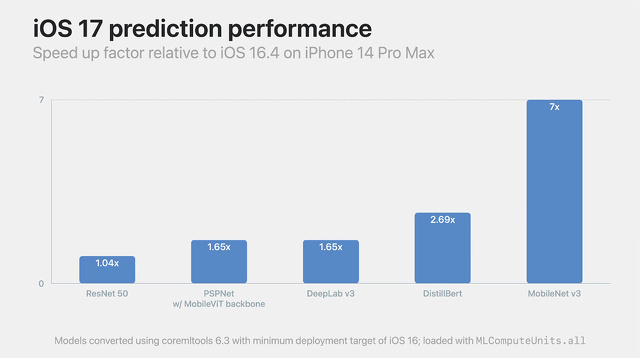

WWDC23:iOS 17、Core ML実行エンジン最大7倍高速化

※本サイトは、アフィリエイト広告および広告による収益を得て運営しています。購入により売上の一部が本サイトに還元されることがあります。

WWDC23において、Core ML実行エンジンの最新改良により、アプリ内の機械学習機能を高速化する方法について説明するセッション「Improve Core ML integration with async prediction」が公開されています。

非同期予測の最新のオプションを紹介し、応答性の高いアプリを作成するために、パフォーマンスと全体のメモリ使用量のバランスをとるための考慮事項を説明します。

iOS 16.4とiOS 17の相対的な予測時間を比較すると、多くのモデルでiOS 17の方が単純に高速であることが観察されます。

この推論エンジンの高速化はOSに付属しており、モデルの再コンパイルやコードの変更などは必要ありません。

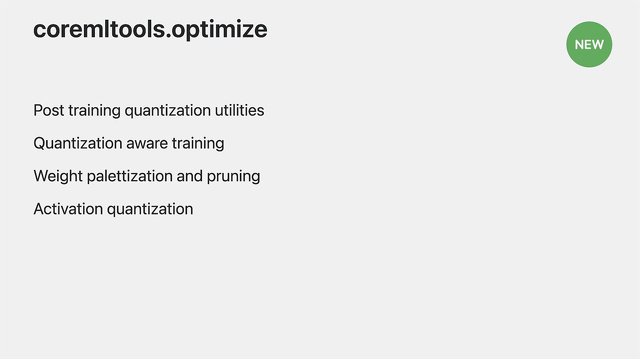

CoreMLToolsパッケージには、新しいoptimizeサブモジュールがあります。

これは、トレーニング後の圧縮ユーティリティを統合して更新し、PyTorch用の新しい量子化認識トレーニング拡張を追加します。

これにより、訓練中に量子化されたモデルの精度を維持するためのデータ駆動型最適化機能を利用できるようになります。

これは、Core ML の ML Program モデルタイプにおける活性化量子化をサポートする新しい操作と連動しています。