WWDC23:新しいVisionKit

※本サイトは、アフィリエイト広告および広告による収益を得て運営しています。購入により売上の一部が本サイトに還元されることがあります。

WWDC23において、VisionKitを使用して、アプリ内の画像から被写体をすばやく持ち上げたり、Visual Look Upで画像の内容を詳しく知ることができる方法について説明するセッション「What’s new in VisionKit」が公開されています。

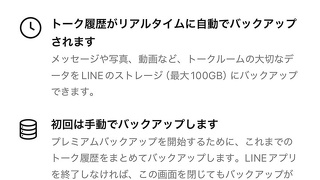

今年、VisionKitがSubject LiftingとVisual Look Upの両方のサポートを追加します。また、テキスト選択のための新しいLive Text API、Catalystのプラットフォームサポートの拡大、macOSネイティブアプリのコンテキストメニュー統合もあります。

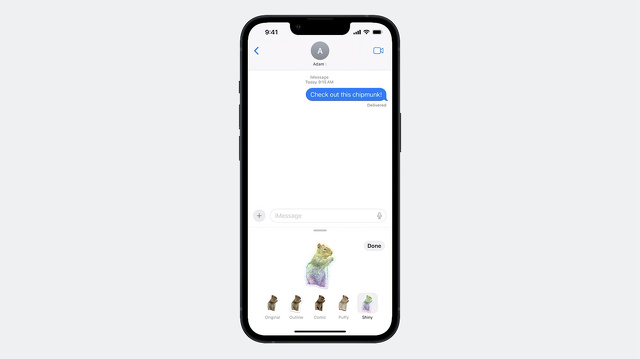

Subject Liftingは、画像の被写体を長押しするだけで、被写体が周囲から浮き上がり、この美しいアニメーションの輝きで強調されます。そして、それを共有したり、Visual Look Upを呼び出すためのいくつかのオプションが表示されます。

iOS 17の新機能として、持ち上げられた任意の被写体を使ってステッカーを作成できるようになり、シャイニー、パフなどの楽しいエフェクトを付けて、友人や家族と共有することができます。

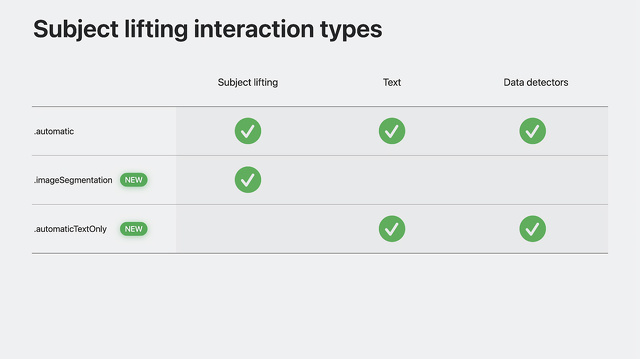

サブジェクトリフティングと互換性のあるインタラクションタイプをもう少し詳しく見てみましょう。

自動は、テキストインタラクション、サブジェクトリフティングなどを組み合わせた、デフォルトのアウト・オブ・ザ・ボックスのエクスペリエンスを提供します。

テキスト選択とデータ検出を行わず、サブジェクトリフティングのみを行いたい場合は、インタラクションタイプを.NETに設定します。

imageSegmentationに設定したり、他のタイプと組み合わせたりすることができます。

最後に、Subject Liftingがアプリにとって意味をなさないが、iOS 16の以前の自動動作が必要な場合は、新しいタイプである.AutomaticTextOnlyを使用できます。

これは、テキスト選択やデータ検出などの機能を提供しますが、Subject Liftingは提供しません。

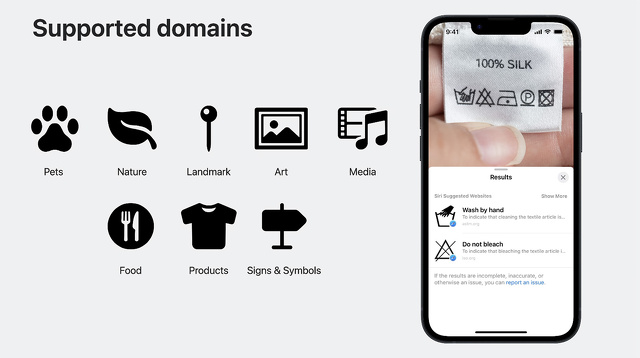

今年のVisionKitはVisual Look Upもサポートしています。

Visual Look Upにより、ユーザーはペット、自然、ランドマーク、アート、メディアを簡単に識別して学ぶことができます。

そしてiOS 17では、Visual Look Upは食べ物、製品、サインやシンボルなど、さらなるドメインをサポートします。

これでようやく、洗濯物のタグに書かれた記号の意味を簡単に調べられるようになりました。

Visual Look Upは言語ごとに用意されており、これらの言語で利用できます。

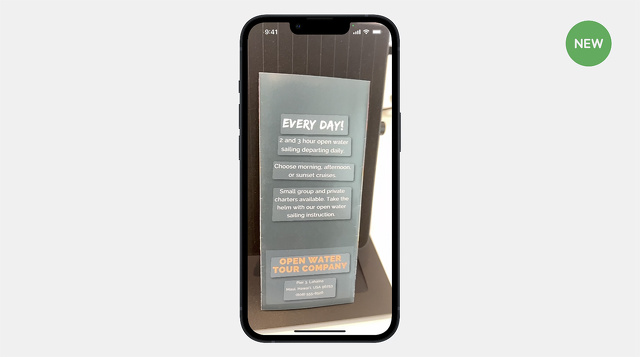

iOS 16で導入されたDataScannerViewControllerは、ライブカメラのビューファインダーでOCRを使用する最も簡単な方法として設計されました。

iOS 17では、オプティカル・フロー・トラッキングと通貨のサポートが強化されています。 オプティカル・フロー・トラッキングは、ライブカメラでの体験のためのテキスト・トラッキングを強化することができます。

iOS 17では、オプティカル・フロー・トラッキングで得られるハイライトが以前よりずっと安定し、地に足がついているように感じられるようになりました。

オプティカル・フロー・トラッキングは、DataScannerViewControllerを使えばいつでも無料で利用できますが、テキストを認識するときのみ利用可能で、機械可読コードは利用できません。

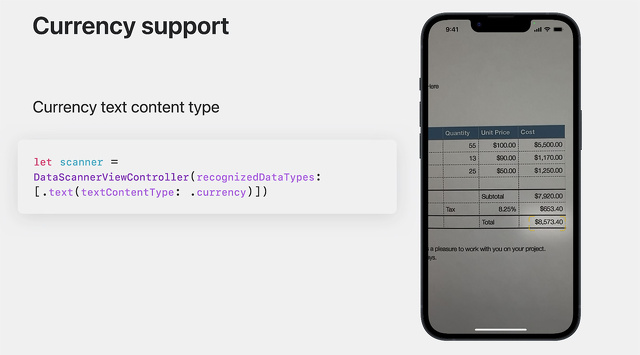

データスキャナーに新しいオプションが追加され、ユーザーが貨幣価値を検索して操作できるようになりました。使い方はとても簡単です。

データスキャナーのイニシャライザーでテキスト認識を指定する際に、電子メールアドレスや電話番号など他のコンテンツタイプと同じように、テキストのコンテンツタイプを通貨に設定するだけです。

データスキャナーでテキスト内の通貨を認識する場合、そのテキストには境界と転写の両方が含まれます。トランスクリプトには、通貨記号と金額の両方が含まれています。

ここでは、レシートのようなもので、すべての値の合計を求める例を挙げます。

まず、現在のロケールを使用して通貨記号を取得します。recognizedItemsストリームでデータスキャナの結果を待つ間に、認識された各項目をループして、そのトランスクリプトを取得することができます。

トランスクリプトに目的の通貨記号が含まれていれば、先に進んで合計値を更新します。このように、すべての値の合計が表示されます。

これは簡単な例ですが、これは非常に強力なもので、これを用いてどんなものが作れるか楽しみです。

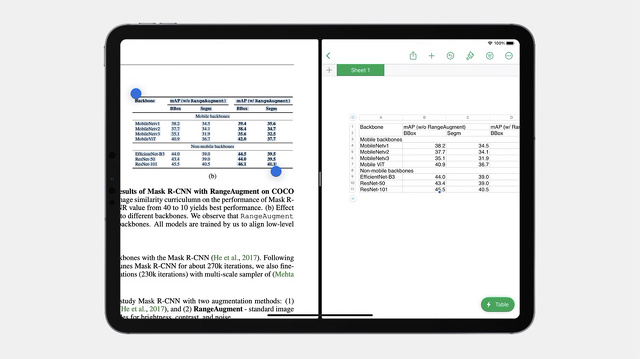

今回、Live Textはテーブルにも同様のサポートを提供し、画像から構造化されたテーブルデータをNotesやNumbersのようなアプリケーションに取り込むのがはるかに簡単になりました。

この表を選択し、コピーしてNumbersに貼り付けると、構造が維持されます。

必要であれば、自動的にセルが結合されることにも注目してください。

このように、数クリックでこの情報をグラフで視覚化することができるようになったのです。

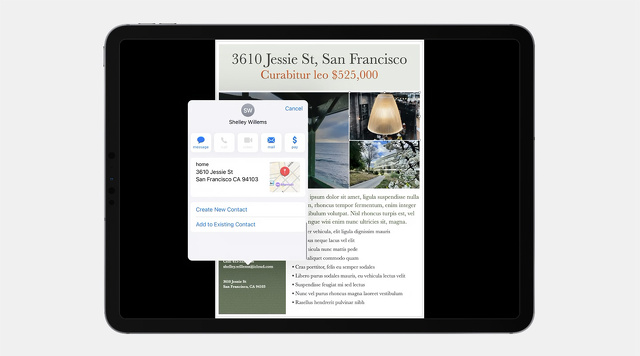

Live Textには、Context Aware Data Detectorsも追加されています。

この機能では、連絡先を追加するときに、データ検出器とその視覚的な関係が使用されます。

メールアドレスから連絡先を追加すると、周囲のデータ検出器からの追加情報が含まれるようになり、一度にすべての情報を簡単に追加できるようになったことに注目してください。

名刺やチラシから連絡先を追加するのは、これまでになく簡単です。

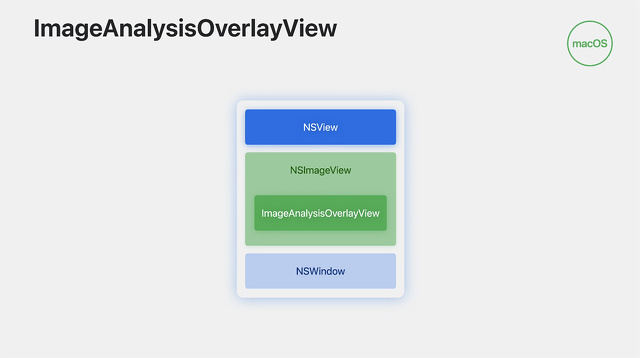

今年は、Macがメインです。iOSアプリのLive Textを簡単にMacに持ち込めるCatalystのサポートを展開します。Catalystで画像解析インタラクションを動作させるには、簡単なリコンパイルで済むはずです。

私たちは、Live Text、Subject Lifting、Visual Look Upをサポートしていますが、残念ながらQRコードのサポートは、Catalyst環境でもVisionKitのネイティブmacOS APIでも利用できません。

しかし、共有の実装であれば、.machineReadableCodesを残すことで対応できることをお知らせしたいと思います。machineReadableCodesをCatalystのアナライザーの設定に残すことは完全に安全であり、ただ、ノーオペになります。

また、Macでこの機能が必要な場合は、Vision FrameworkでQR検出のサポートが利用可能であることに注意してください。