iOS 14/iPadOS 14:ARKit 4の新機能

※本サイトは、アフィリエイト広告および広告による収益を得て運営しています。購入により売上の一部が本サイトに還元されることがあります。

Appleが、WWDC20において「Explore ARKit 4」「Build Image and Video Style Transfer models in Create ML」を公開し「ARKit 4」について解説しています。

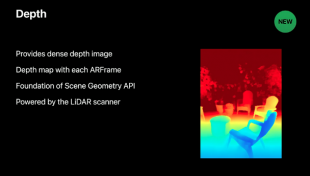

iPadOS 14では、まったく新しいDepth APIが導入され、iPad ProのLiDARスキャナーによって収集された詳細な深度情報にアクセスするための新しい方法が作成されます。

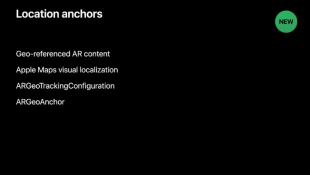

iPhone XS、iPhone XS Max、iPhone XR以降のiPhoneで、ロケーションアンカーを使用し、特定の緯度、経度、高度の座標でARの作成物をアンカーすることが可能になります。

ユーザーは、仮想オブジェクトを移動して、実際のオブジェクトがカメラのレンズを通して見られるのとまったく同じように、異なる視点からそれらを見ることができます。

LiDARスキャナーに組み込まれた高度なシーン理解機能により、周囲の環境に関するピクセルごとの深度情報を使用できます。

シーンジオメトリによって生成された3Dメッシュデータと組み合わせると、仮想オブジェクトを瞬時に配置し、それらを物理的な環境とシームレスにブレンドすることで、仮想オブジェクトのオクルージョンをさらにリアルにします。

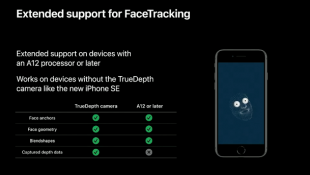

TrueDepthカメラを搭載しないiPhone SE (2nd generation)や、A12 Bionicチップ以降を搭載したiPhone XR、iPhone XS、iPhone XS Max、iPad Air (3rd generation)、iPad mini (5th Generation)でも前面カメラを使用してAR体験を楽しむことができます。

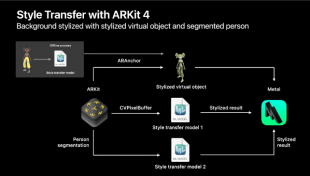

ARKit 4オブジェクトを、身体の動きを学習させたCreate MLによって動かし、Vision Frameworkにより、実際にカメラ前で踊る人と合成することが可能になります。

配置するARKit 4オブジェクトは1つではなく複数配置が可能です。