WWDC21:Apple、カメラ機能の提供の仕方を刷新

※本サイトは、アフィリエイト広告および広告による収益を得て運営しています。購入により売上の一部が本サイトに還元されることがあります。

Appleが、WWDC21において、カメラの新機能について紹介する「What’s new in camera capture」を公開しています。

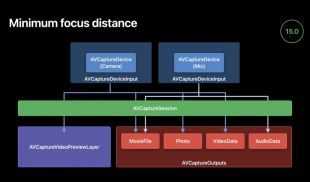

新機能は全て「AVFoundation framework」に含まれています。

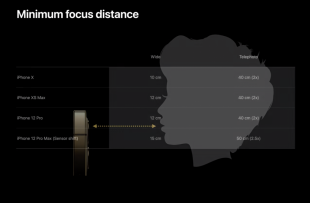

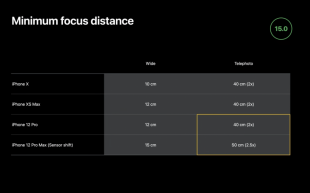

最短撮影距離とは、レンズからシャープなピントが得られる最も近い点までの距離のことで、iPhoneのカメラにも最短撮影距離がありますが、これまで公表されていませんでした。

iOS 15からは、iPhoneのオートフォーカスカメラの特性として、最短撮影距離が公開されます。

iPhone 12 ProとiPhone 12 Pro Maxの広角カメラには顕著な違いがあり、Proでは最短距離が12cmであるのに対し、Pro Maxでは15cmでフォーカスしています。

これは、iPhone 12 Pro Maxに搭載されているセンサーシフト方式の手ぶれ補正技術によるもので、同様に、望遠カメラの最短撮影距離は、12 Proよりも12 Pro Maxの方が遠くなっています。

これは、望遠レンズの到達距離が長くなったことによるものです。2倍ズームに対して2.5倍ズームになっています。

iOS 15の新機能として、カメラの水平視野、スキャンしたいバーコードの最小サイズ、カメラのプレビューウィンドウの幅があれば、ちょっとした計算をして、そのプレビュー幅を埋めるのに必要な最小被写体距離を計算できます。

そして、カメラの新しいminimumFocusDistanceプロパティを使って、カメラがそこまでピントを合わせられないことを検出し、ユーザーが退くように誘導するのに十分な大きさのズームファクターを計算します。

そして最後に、設定のためにカメラをロックし、ズームファクターを設定してからロックを解除することで、カメラに適用します。デモアプリをリコンパイルすると、UIが自動的に正しいズーム量を適用するようになりました。

iPhone XSのカメラにHDR動画のようなソリューション「EDR」(Extended Dynamic Range)を導入しました。

EDRは、標準露光と短時間露光を交互に行うことで、撮影フレームレートを実質的に2倍にしますが、撮影の間に垂直方向のブランキングがほとんど発生しないようにタイミングを調整しています。

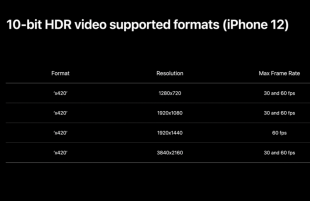

iPhone12シリーズから「10-bit HDR 動画」撮影が導入され、720p、1080p、4Kなど、最も一般的なビデオフォーマットすべてに対応しています。

また、4×3フォーマット(1920×1440)にも対応しており、12メガピクセルの高解像度写真にも対応しています。

Control Centerのビデオエフェクトが導入され、簡単に言うと、これらはシステムレベルのカメラ機能で、コードを変更することなくアプリで利用でき、ユーザーがコントロールできます。

従来は、iOSやmacOSに新しいカメラ機能を導入すると、Appleのアプリはすぐにそれを採用し、Appleが新しいAVCapture APIを公開すると、デベロッパーはそれについて学び、自分のペースでその機能を採用します。

これは安全で保守的なアプローチですが、その結果、ユーザーがお気に入りのカメラアプリの素晴らしい機能を利用できないまま、長いリードタイムを過ごすことになりがちです。

Control Centerのビデオエフェクトでは、システムレベルでパッケージ化されたカメラ機能を導入しています。

iPad ProのM1モデルに搭載され、12メガピクセルのウルトラワイド前面カメラを利用した「センターフレーム」(Center Stage)は、FaceTimeビデオ通話の演出効果を高めます。

また、他のあらゆるビデオ会議アプリでも、すぐに使えます。

センターフレームは、iPad ProのM1モデルのすべてのフロントカメラで利用できます。

新しいフロントカメラである超広角カメラでも、従来の視野を切り取ったバーチャルワイドカメラでも、バーチャルTrueDepthカメラでも、センターフレームを利用することができます。

すべてのビデオ会議アプリに搭載されている新機能として「ポートレート」というものがあります。

ポートレートモードでは、美しく表現された被写界深度の浅い効果を得ることができ、単なるプライバシーボケではなく、Appleのニューラルエンジンに加え、トレーニングされた単眼の深度ネットワークを使って、レンズを開放した本物のカメラに近づけています。

iOSでは、Apple Neural Engineを搭載したすべてのデバイス(2018年以降の機種)でポートレートがサポートされています。

サポートされるのは前面カメラのみで、同様にApple Neural Engineを搭載したすべてのM1 Macでもサポートされています。

ポートレートは、計算量の多い複雑なアルゴリズムなので、そのため、ビデオレンダリングのパフォーマンスを維持するために、最大解像度は1920×1440、最大解像度は毎秒30フレームに制限されています。

マイクモードはAVFoundationのAVCaptureDeviceインターフェイスに表示され、標準的なオーディオDSPを使用する「スタンダード」、デバイス周辺のすべての音をキャプチャするために処理を最小限に抑えるが、エコーキャンセルも含まれる「ワイドスペクトラム」、音声を強調し、キーボードのタイピングやマウスクリック、近所のどこかで稼働している除草機などの不要なバックグラウンドノイズを除去する「ボイスアイソレーション」の3つの種類があります。

これらのフレーバーは、コントロールセンターでユーザーが設定することができます。

マイクモード処理は、2018年以降のiOSおよびmacOSデバイスでのみ利用可能です。

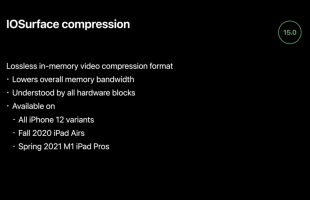

iOS 15では新たに、ロスレスのメモリ内ビデオ圧縮フォーマットのサポートが導入されます。

これは、ライブビデオの総メモリ帯域幅を下げるための最適化で、このフォーマットは、iOSデバイスやMacの主要なハードウェアブロックで理解できる交換フォーマットです。

iPhone 12のすべてのモデル、iPad Air (第4世代) 、iPad ProのM1モデルで利用できます。

iOS のカメラは 420v と 420f という 8 ビットの YUV フォーマット(ビデオとフルレンジ)をネイティブにサポートし、10-bit HDR 動画フォーマットであるx420もサポートしています。

映像データの出力は、要求に応じて16ビット/ピクセルのBGRAに内部拡張することもできます。

これらはそれぞれIOSurfaceで圧縮されていますが、iOS 15からはAVCaptureVideoDataOutputで要求できるようになります。