WWDC21:画像から文字認識する高度な画像解析技術「テキストの認識表示」について紹介

※本サイトは、アフィリエイト広告および広告による収益を得て運営しています。購入により売上の一部が本サイトに還元されることがあります。

WWDC21において、Appleが、デバイス上の知能を使って写真の中のテキストを認識し、ユーザーがアクションを起こせる「テキストの認識表示」(Live Text)について紹介するセッション「Use the camera for keyboard input in your app」が公開されています。

テキストの認識表示を使用することで、電話番号、住所、フライト情報などのデータをアプリで入力するのに役立ちます。

テキストの認識表示機能は、A12 Bionic以降を搭載したiPhone、iPad、およびM1チップを搭載したMacで使用可能です。

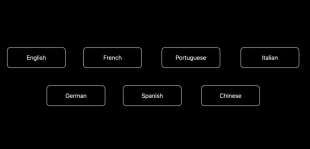

また、対応する言語は、英語、フランス語、ドイツ語、イタリア語、スペイン語、ポルトガル語、中国語の7カ国語で、iOSの優先言語で、これらの言語が選ばれている場合のみ利用できます。

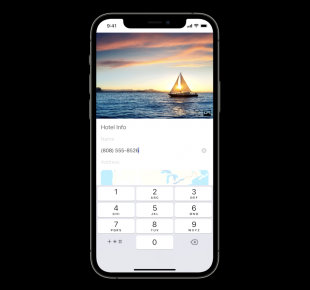

例としてデモ用旅行アプリで実装状況を説明します。

旅行先の場所を登録する時に、ホテル名、電話番号、住所の入力項目があったとします。

電話番号フィールドを2回タップすると、編集メニューに「カメラからのテキスト入力」を使用するための新しいオプションが表示されます。

起動すると、カメラはドキュメント上のこのテキストグループを即座に認識し、表示されたテキスト情報から電話番号だけを選択できます。

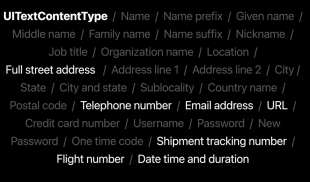

iOS 15、iPadOS 15、macOS Montereyでは、テキストコンテンツフィルターとして、従来の電話番号、住所、URL、メールアドレスに加えて、航空便の便名、貨物追跡番号、日付、時刻、期間の組み合わせの3つのタイプが追加されました。

オートコレクトや予測テキストの候補がない場合、iOS 15にはカメラにすばやくアクセスするためのボタンが用意されています。

編集メニューは、2回目のタップでのみ表示され、候補バーには、前に示したボタンの代わりに予測テキストが表示されます。

したがって、カメラ入力を示唆するボタンを画面上に表示したい場合は、専用のランチャーボタンを追加する必要があります。

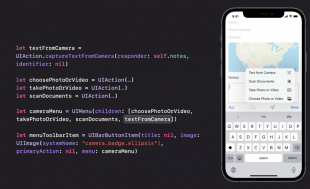

そのためには、まずiOS 15の新機能である「captureTextFromCamera」インスタンスメソッドを使用してUIActionを作成する必要があります。