WWDC22:画像認識機械学習モデル「Vision」のアップデートを紹介

※本サイトは、アフィリエイト広告および広告による収益を得て運営しています。購入により売上の一部が本サイトに還元されることがあります。

Appleが、WWDC22において、アプリケーションがテキストを認識し、顔と顔のランドマークを検出し、オプティカルフローを実装するのに役立つ「Vision API」の最新のアップデートについて紹介する「What's new in Vision」を公開しています。

Visionは2017年に初めて導入され、それ以来、Visionが提供する技術を使って何千もの素晴らしいアプリが開発されています。

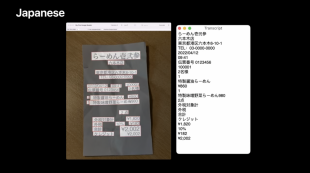

Live Text 機能を実現するためのテキスト認識機能「VNRecognizeTextRequestRevision3」により、日本語と韓国語の文字が認識出来るようになります。

また、テキスト認識については、新たに自動言語判別機能を搭載しました。

automaticallyDetectsLanguageをtrueに設定して、テキスト認識エンジンに自動的に言語を検出するように依頼することができます。

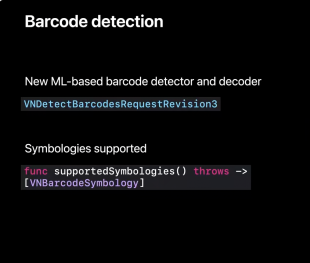

以前のリビジョンとは一線を画す新しいバーコード検出機能「VNDetectBarcodesRequestRevision3」が用意され、最新の機械学習を活用しています。

バーコードには、店頭の商品についているバーコードから、QRコード、ヘルスケア用途の特殊コードまで、さまざまな記号があります。

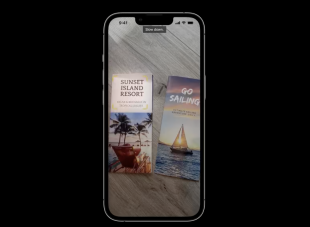

MLを使っていることもあり、一度に1つのコードを検出するのではなく、一発で複数のコードを検出するため、複数のコードを含む画像では要求速度が速くなります。

また、精度が上がるため、多くのコードを含む画像では、より多くのコードが検出されます。そしてさらに、重複して検出されることは、ほとんどありません。

一部の符号、特にean13などの線形符号について、従来は線が返されていたバウンディングボックスを改善した。

現在では、バウンディングボックスは目に見えるコード全体を囲み、さらに、これまで検出精度を妨げていた曲面や反射などのアーチファクトを無視できるようになりました。

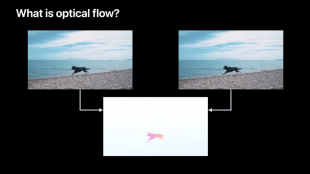

新しいリビジョンとして「VNGenerateOpticalFlowRequestRevision2」という、オプティカルフローリクエストが追加されます。

オプティカルフローは、2つの連続した画像、通常はビデオのフレームを分析します。

浜辺を走る犬が写っている映像がある場合、左の画像から右の画像へ、犬は少し左に移動したように見えます。

オプティカルフローを実行すると、 暗い部分が動きを検出した部分ですが、確かに犬の形と同じように見えます。

これは、このシーンで本当に動いているのは犬だけだからです。

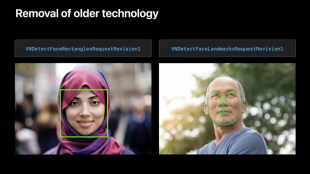

顔検出と顔ランドマークは、5年前のVisionリリース時に、各アルゴリズムの「リビジョン1」として初めて紹介しました。

その後、より効率的で精度の高い技術を用いた2つの新しいリビジョンをリリースしています。

そこで、Visionフレームワークでは、これらのアルゴリズムの最初のリビジョンを削除し、2番目と3番目のリビジョンのみを残しています。