WWDC24:Platforms State of the Union(Apple Intelligenceの仕組みを解説)

※本サイトは、アフィリエイト広告および広告による収益を得て運営しています。購入により売上の一部が本サイトに還元されることがあります。

Appleが、WWDC24において「Platforms State of the Union」を公開しました。

パワフルな生成モデルをもたらすパーソナル人工知能システム「Apple Intelligence」は、システム全体の機能やアプリに深く統合され、プライバシーを考慮して一から作られています。

何年もの間、AppleのプラットフォームはAppleシリコンのパワーを最大限に活用することでオンデバイスの機械学習タスクの実行において先頭に立ってきました。

できる限りのことをデバイス上で実行するのは低遅延とより良いユーザー体験を実現するためです。

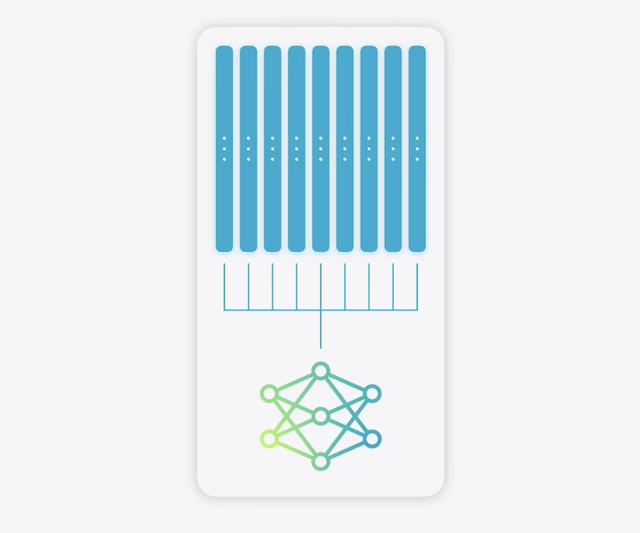

Apple Intelligenceはオンデバイスの基盤モデルで始まります。

これは高性能な大規模言語モデルです。

Appleは最高の着地点を探し、目指す体験を可能にするパワーとデバイス上で動作する小ささです。

基盤モデルに関して解決すべき重要な課題が3つありました。

・実行したい多くのタスクや機能に最適になるよう特化すること。 ・iPhoneのようなデバイスに収まるよう小さくすること。 ・可能な限り最高の推論パフォーマンスとエネルギー効率を実現すること。

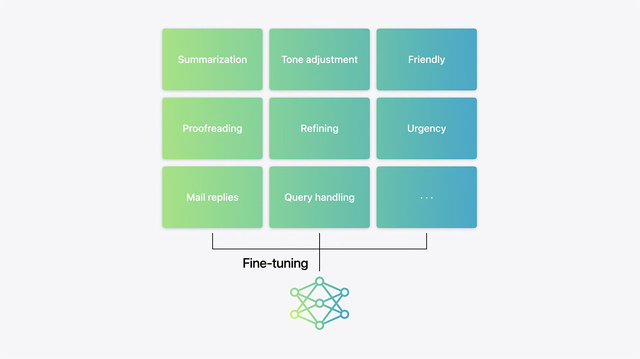

最初に使う技法は「ファインチューニング」です。

Appleのモデルにそれそれ異なるトレーニングパスを行い、テキストの要約、校正、返信メール作成など与えられたタスクを高度に行えるよう教えます。

このプロセスは一つのことには優れていますが、他のことは得意ではない一連の特化したモデルを生みます。

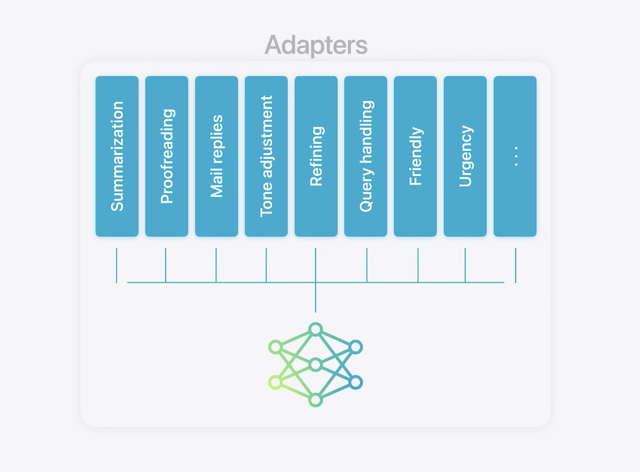

ファインチューニングのより効率的なアプローチは「アダプタ」という新しい技法を利用することです。

アダプタはコモンベースの基盤モデルに重ねられたモデル重ねの小さなコレクションです。

ロードやスワップをダイナミックにできるので、基盤モデルを当座のタスクに急いで特化させることができます。

Apple Intelligenceは豊富なアダプタを備えていて、それぞれが特定の機能のためにファインチューニングされています。

これが基盤モデルの機能を強化する効率的な方法です。

次のステップはモデルの圧縮です。

最先端の量子化技術を使い1パラメータ当たり16ビットのモデルをApple Intelligence対応のデバイスに収まる1パラメータ当たり平均4ビット未満にします。

一方モデルの品質は維持しました。

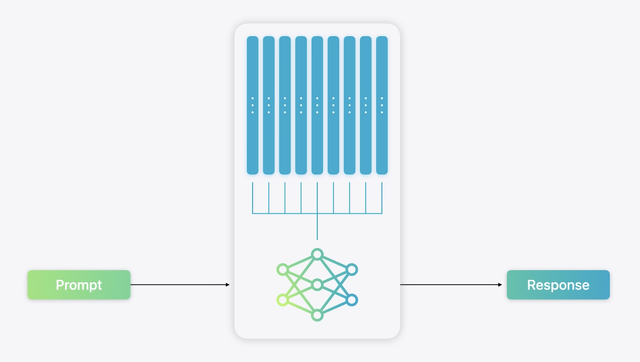

最後に、Appleは推論パフォーマンスと効率性に注目し、プロントの処理と反応の生成を最短でできるようモデルを最適化しました。

Appleは投機的デコーディングやコンテクストの枝刈り、グループクリアテンションなど幅広い技術を取り入れ、Neural Engineを最大限に活かせるようにそれら全てを調整しました。

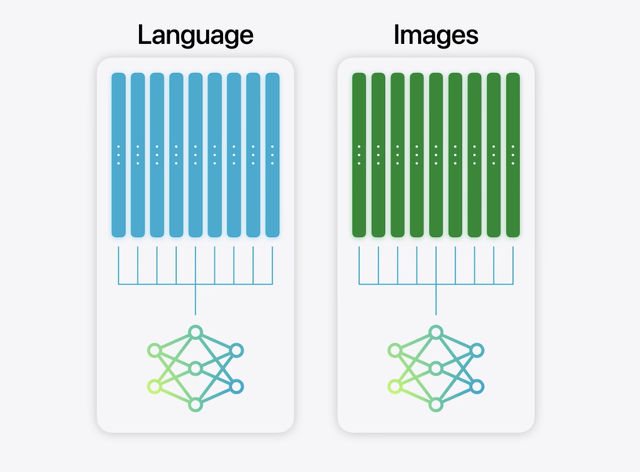

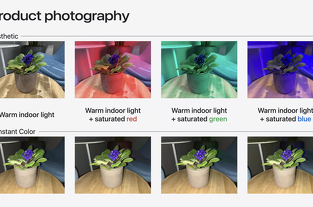

同様のプロセスを画像を生成する拡散モデルにも適用しました。

これは様々なスタイルのGenmojiのアダプタを使用します。

これがオンデバイスのApple Intelligenceです。

パワフルで直感的であり統合された言語と拡散モデルは素晴らしいパフォーマンスを実現し、手の中に収まる小さなデバイス上で動作します。

さらに高度な機能も備えているので複雑なデータを推論するためにより大きいモデルが必要です。

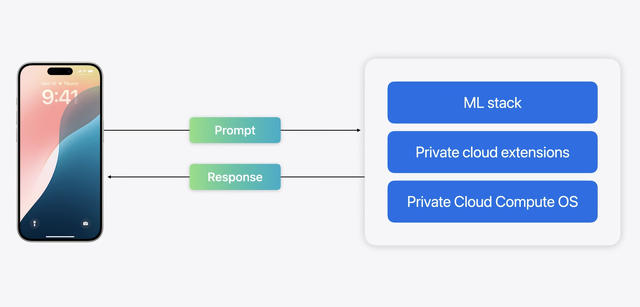

そこでより大きな基盤モデルを実行するためにApple Intelligenceを「Private Cloud Compute」によってクラウドへと拡張しました。

これらのモデルはユーザーのパーソナルな情報を処理するので、Appleはクラウドコンピュートを再考し、デバイスにおけるプライバシーへのアプローチをサーバにまで拡張する必要がありました。

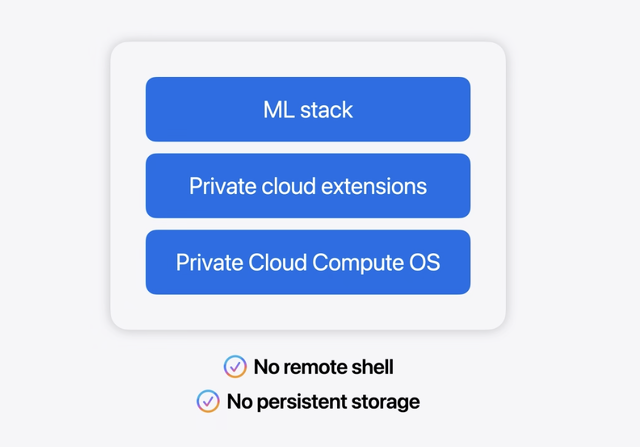

Private Cloud Computeはプライバシーを保護しながらAIを処理することに特化してデザインしています。

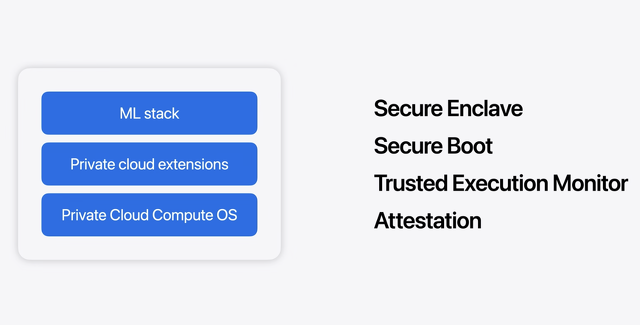

iOSの基盤である要塞化されたサブセットを使用する新しい「Private Cloud Compute OS」で動作します。

業界トップのオペレーティングシステムのセキュリティ機能に基づくものです。

専用のAIサーバには必ずしも必要ではない機能は削りました。例えば永続化されたデータストレージです。

通常、サーバ管理に使われるツールを完全に置き換え、リモートシェル経由のようなユーザーのデータへのアクセスを許可しうる特権アクセスを防ぐよう設計されています。

人工知能を強化するための豊富な機械学習スタックを備えています。

その結果はAppleシリコンをもとにした比類ないクラウドセキュリティ基盤です。

まずは重要な暗号鍵を保護するための「Secure Enclave」です。

iOSと同様にセキュアブートはOSが署名と認証されたことを確実にします。

Trusted Execution Monitorは、署名と認証がコードのみが実行されるようにします。

アテステーションはユーザーのデバイスがリクエストを送る前にPrivate Cloud Computeクラスタのアイデンティティと構成を安全に確認できるようにします。

それぞれの要求ごとにユーザーのデバイスはPrivate Cloud Computeクラスタとエンドツーエンドで暗号化された接続を築きます。

選別されたクラスタだけがリクエストしたデータを解読でき、レスポンスを返したあとはデータを保持することはなく、Appleは決してアクセスできません。

Private Cloud Computeの全てのプロダクションビルドの仮想イメージの作成に取り組んでおり、それはセキュリティ研究者の調査に対して公に利用可能となるため、彼らはAppleが約束を守っているかを検証でき、発見に対してはApple Security Bountyから報酬があります。

第2にユーザーのデバイスが調査のために公に記録された署名済みのビルドだけを実行するPrivate Cloud Computeクラスタとのみ通信するようにしました。

この規模のクラウドAIコンピュートにデプロイされた最もセキュリティアーキテクチャーだと考えています。

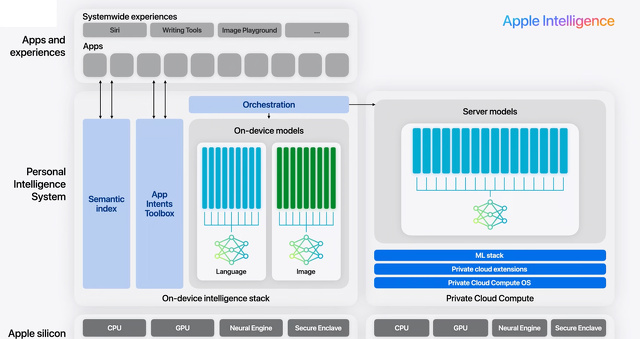

Apple Intelligenceはこれら全てをひとまとめにするパーソナル人工知能システムです。

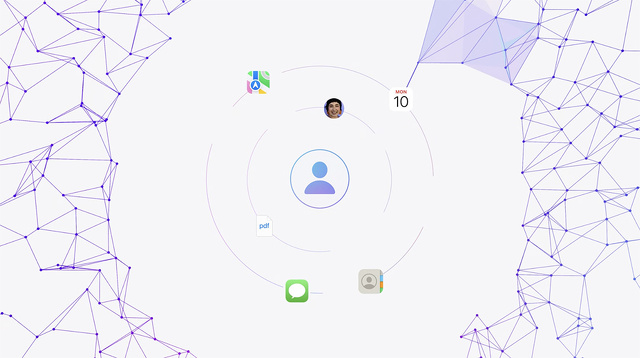

オンデバイスのセマンティックインデックスも備えており、アプリを横断してパーソナルな情報を組織できます。

App Intent Toolboxは、アプリの機能を理解しユーザーに代わって起動することができます。

ユーザーがリクエストを送るとApple Intelligenceがオンデバイスの知能スタックかPrivate Cloud Computeを使いその処理方法を調整します。

そしてセマンティックインデックスを利用して各リクエストを関連するパーソナルコンテクSトにもとづかせApp Intent Toolboxを使ってユーザーのために実行します。

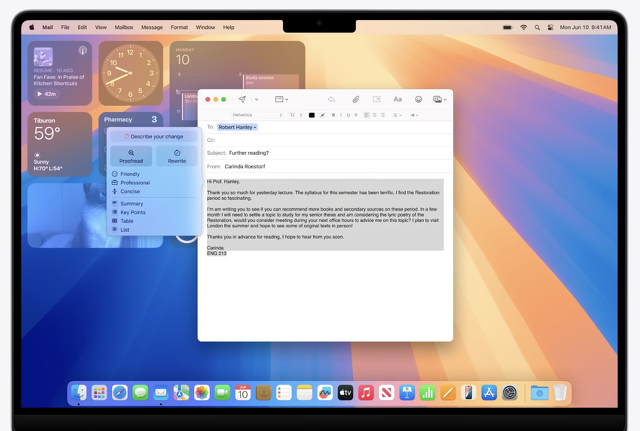

テキストフィールドのレンダリングに標準のUIフレームワクを使っているならアプリが自動で記述ツールを取得します。

そして新しいTextViewDelegate APIを使うと記述ツールがアクティブな時のアプリの挙動をカスタマイズできます。

例えばApple Intelligenceがテキストを処理中同期を一時停止することで競合を避けます。

Genmojiがまったく新しいコミュニケーションの扉を開きユーザーはその瞬間に適した新しい絵文字を作れます。

内部では Genmojiは絵文字と違う方法で処理されます。

絵文字はただのテキストですがGenmojilは「AttributedString」使って処理されます。

これはグラフィックス入りのリッチテキストを表示するためにAppleが長年使ってきたデータ型です。

Apple Intelligenceは すべてのアプリで楽しいオリジナル画像を作るためにシステム全体の 素晴らしい新機能も提供します。

新しい「Image Playground API」は一貫していて遊び心があり使いやすい体験を届けます。

採用するとメッセージやKeynoteや新しいImage Playgroundアプリでユーザーにおなじみの体験を利用できます。

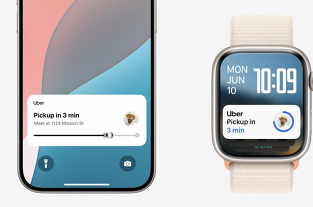

Siriは2024年にアプリ内とアプリ間で数々の新しいアクションが可能になります。

これは「App Intent」に施している大幅な強化によって可能になりました。

App Intentは Siriやショートカットやほかのシステム体験における一連のアクションを定義するフレームワークです。

App Intentは、Apple Intelligenceをアプリで活用するパワフルな方法になりました。

さらに追加作業がなくても アプリに役立つ新しいSiriの機能が2つあります。

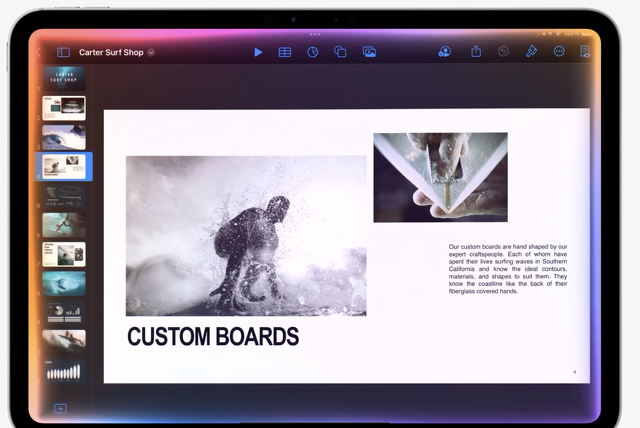

まずは Siriがアプリのメニューからどんなアイテムも呼び出せることです。

スライド資料を見ているユーザーが[発案者ノートを表示」と言ったり、もしくは もっと会話的に「発案者を見たい」と言った時もSiriは何をすべきかわかります。

2つ目はApple標準のテキストシステムを使ったアプリなら表示されたテキストにSiriがアクセスできることです。

これでユーザーは画面上に見えるテキストに直接言及して操作できます。

ユーザーが祖父の誕生日を祝うというリマインダーを見ているなら「FaceTime hin:」と言えばいいのです。

Apple Intelligenceは写真やメッセージやファイルやカレンダーの予定などのセマンティックインデックスにアクセス可能になるので、これまでは不可能だった物事を見つけて理解できるようになります。

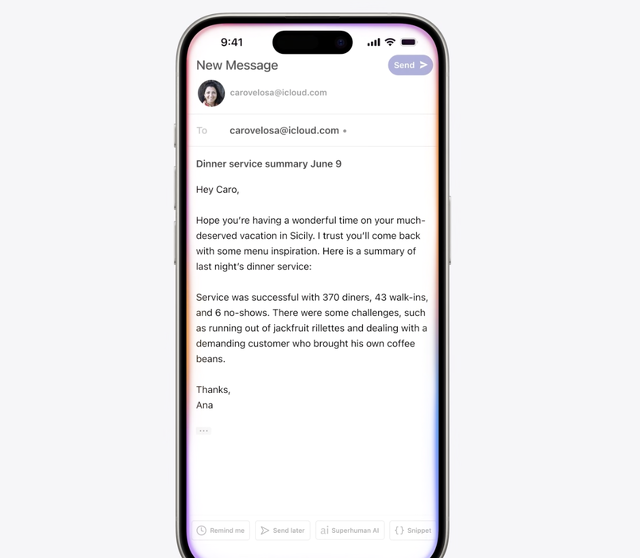

例えばユーザーはメモアプリで取ったメモの要約をSuperhumanで下書きしたメールに追加できます。

メールの下書きがインデックス向けにアプリのエンティティとして定義されると、ユーザーは会話的に言及できます。

そしてSiriはメモの内容をSuperhumanアプリのユーザーが望むところに追加できます。

Apple IntelligenceによってSiriは アプリのデータや機能に対して、これまで以上に深く自然なアクセスが可能になります。

今年 Visionフレームラークにはまったく新しいSwift APIが搭載されます。

Create MLを使いトレーニング用の追加データを取り込めば、それらの機能を拡張できます。

例えば独自の画像データセットがあるなら、みなさんのデータで私たちの画像モデルを拡張して、分類と物体検出の機能を向上させることができます。

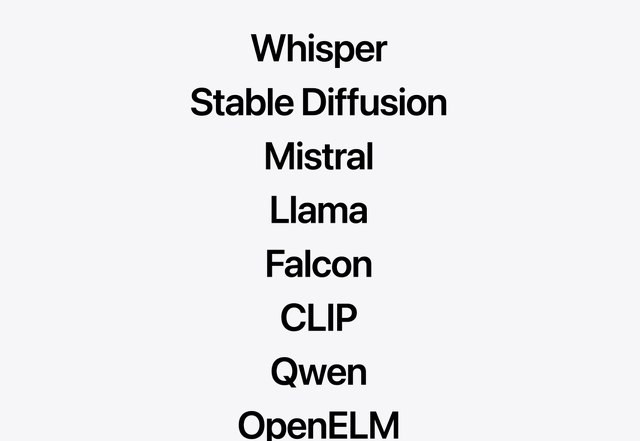

オンデバイスAIモデルをインポートし実行することもできます。

大規模言語モデルにおける量子化や効率的なキー値キャッシングなどApple Intelligenceで使われる多くの技法を活用できます。

MistralのHugging Face Spaceから「Mistral 7B」パラメータモデルを使います。

Core MLフォーマットに変換され、Swift,Kanstormersパッケージを使って作られたテストアプリの中で実行中です。

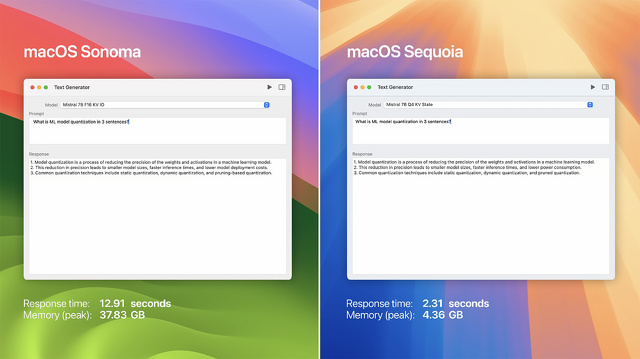

macOS Sonomaでは16ビットモデルとして動作し、macOS Sequoia用には最新の4ビット量子化とステートフルKVキャッシュ技術をCore MLに適用しました。

モデルには単純な質問「MLモデル量子化を3文で説明すると?」を与えました。

倍以上速く ほぼ9倍のピーク時の省メモリでモデルは回答を生成できます。

量子化はパワフルな技術ですが出力の質に影響するので、あとで追加のテストとチューニングを行うことを推奨します。

RealityKitはリアル調やセル画調カートゥーン調など様々なスタイルの3Dモデルをレンダリングするプロセスをシンプルにします。

iPhone、iPad、Macから導入が始まったRealitvKitは、Vision Proの発表に合わせ、非常に新しい機能を獲得しました。

これとともに使える新しいツール「Reality Composer Pro」は、空間アプリの開発をシンプルにするものですが、visionOSのみの対応でした。

今年 これらのAPIとツールは「RealityKit 4」で、macOSとiOSとiPadOSにも対応します。

ですからそれらの全プラッフォームに向け一度で簡単にビルドできるのです。

Apple Vision ProはSharePlayアプリとともに共有体験を通じ ユーザーが友だちや家族とつながるのを助けます。

テーブルを中心とした共同体験の開発を容易にするフレームワークとして「TabletopKit」を作りました。

TabletopKitはカードや駒の操作配置やレイアウト ゲームボードの定義など大変な仕事を担います。

さらに空間PersonaやSharePlayとシームレスに連係するので、ユーザーは一緒にソーシャルゲームをプレイできます。

visionOS 2は、まったく新しい「Enterprise API」が空間バーコードのスキャンや、低遅延の外部カメラストリーミングなどへのアクセスを提供します。

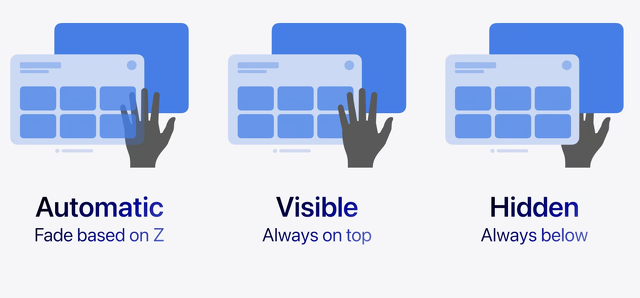

ユーザーの手がコンテンツの前と後ろのどちらに見えるか選べるようになり、アプリ体験に さらなる創造性を与えます。

シーン解析機能の忠実度を大幅に向上させました。

平面は あらゆる方向で検出されるようになり、みなさんの周囲の平面に物体を固定できます。

ユーザーの周囲を 部屋ごとに判断する「Room Anchors」の概念を追加しました。

部屋を横断するユーザーの動きも検出できます。

そしてvisionOS 2用の新しいオブジェクトトラッキングAPIにより、ユーザーの周りの個々の物体にコンテンツを追加できるようになりました。

この新しい機能により説明文のような仮想コンテンツを物理オブジェクトに追加することができ、新しい次元のインタラクティブ性がもたらされます。