Apple、iOS 18.2、iPadOS 18.2、macOS Sequoia 15.2で画面上のコンテンツを理解する視覚言語モデル (VLM)を実装

※本サイトは、アフィリエイト広告および広告による収益を得て運営しています。購入により売上の一部が本サイトに還元されることがあります。

Appleが、デベロッパー向けドキュメント「Making onscreen content available to Siri and Apple Intelligence」を公開し、iOS 18.2以降、iPadOS 18.2以降、macOS Sequoia 15.2以降で、Siri と Apple Intelligence を有効にして、アプリの画面上のコンテンツに対するユーザーの質問やアクション要求に応答できるようになると説明しています。

アプリの画面上のコンテンツを、Siri と Apple Intelligence の現在および今後のパーソナルインテリジェンス機能と統合するには、App Intents フレームワークを使用して画面上のコンテンツを明示的に提供することが必要になります。

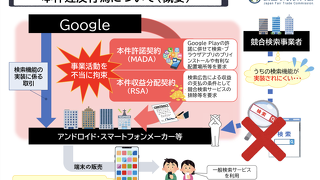

この視覚言語モデル (VLM)の実装は、Appleは「ReALM」として論文を発表済みで、Googleもインフォグラフィックスとユーザーインターフェースを理解するためのマルチモーダルAIモデル「ScreenAI」として発表しています。